(最新進展:LLM對於含有過程的回答較有自信)

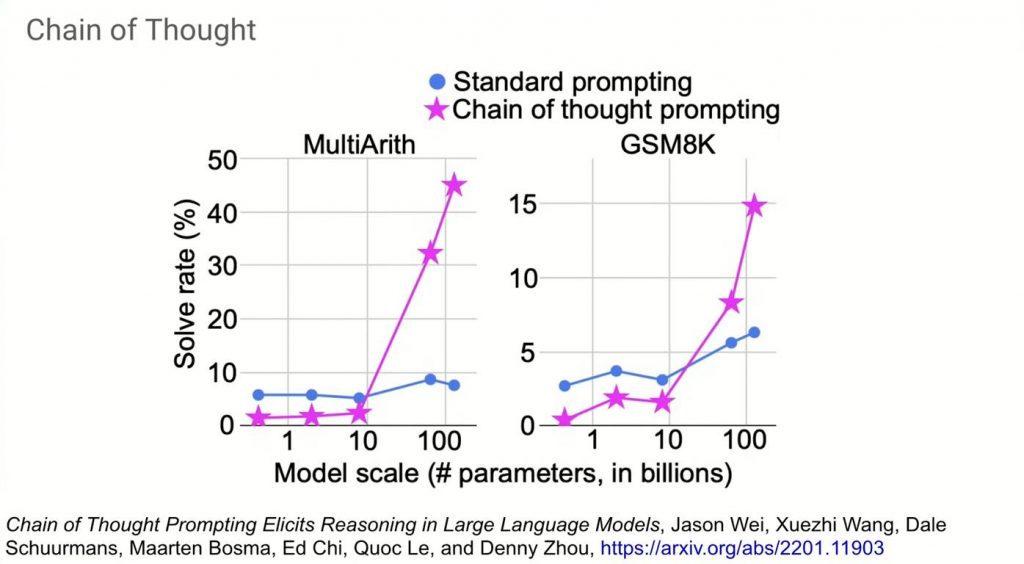

Google大神Jeff Dean在RICE University演講時也分享了「Chain of Thought (簡稱CoT)」

演講連結:https://youtu.be/oSCRZkSQ1CE?si=2QKRt4ARw_KVs8Ez&t=532

▌一句話講 Chain of Thought

1. CoT核心想法:循循善誘LLM寫出過程,可以提高正確率

2. CoT最新進展:LLM對於自己含有過程的回答較有信心

▌如何使LLM寫出過程、增加準確度

兩種方法:

1. 每一個問題最後都加上 「Let’s think it step by step」

2. 在Prompt裡面提供自己一步一步推理的回答範例,再請LLM照模板回答

附個Prompting參考說明書:https://www.promptingguide.ai/zh/techniques/cot

▌最新進展:回答若含有過程,LLM對自己更有信心

大家有注意過ChatGPT有個鍵可以重新生成回答嗎?

其實,LLM是可以吐出不同回答的!

DeepMind一週前的最新研究「Chain-of-Thought Reasoning Without Prompting」指出

當邏輯推理過程出現在其中某個回答時

模型對於這個答案的自信 (Confidence)越高

且通常這個答案是對的

也就是說

面對邏輯推理問題

大家可以看關鍵字詞的位置,若關鍵字詞在一開頭就出現

那很大機率LLM在唬爛,他想都沒想

這時可以重新產生回答

直到看到有推理過程的回答,再採信就好!

附個論文連結:https://arxiv.org/abs/2402.10200

(但我覺得GPT-5來了後,這一切或許就不是個問題了