Jeff Dean是DeepMind和Google Research的首席科學家

前幾天在RICE University給了一個演講

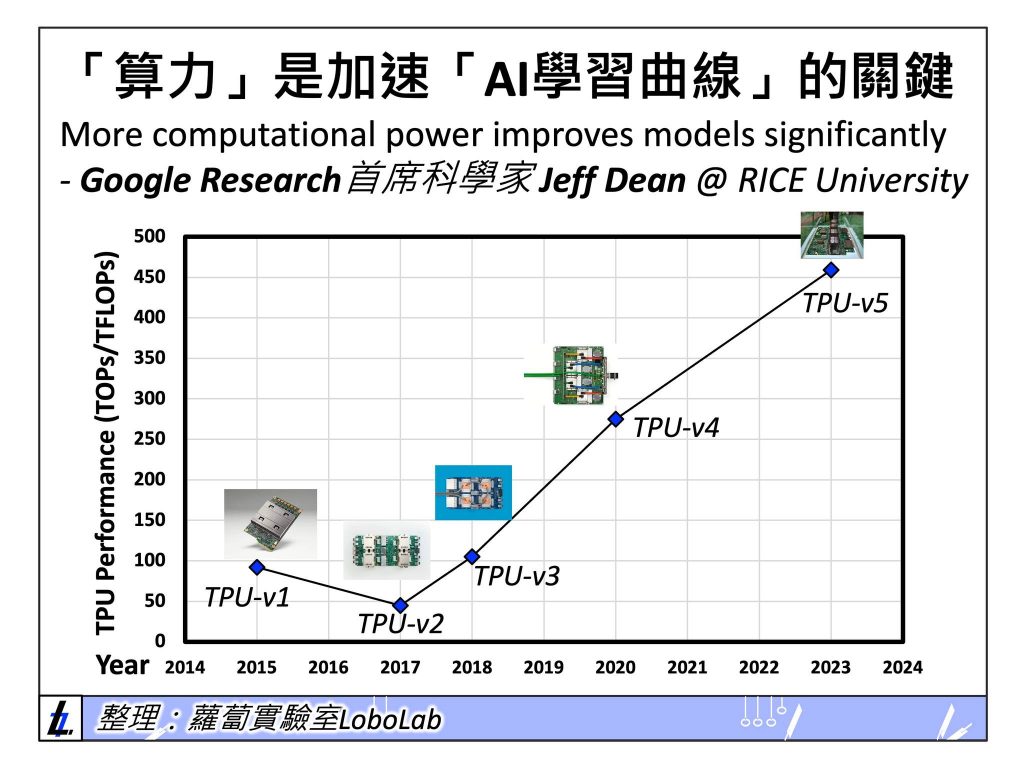

其中很大一部分在分享自研的AI晶片Tensor Processing Unit (TPU)

從規格到背後邏輯都分享了一些

其中,之所以TPU已經成為Google重要專案,是因為

「算力」是加速「AI學習曲線」的關鍵

以及

「自研晶片」可大幅降低算力的成本

▌Google的十年AI晶片大業 (TPU-v1到TPU-v5)

很難想像軟體龍頭Google的TPU專案已經發展了近十年吧

從v1到v5,總結一下TPU的亮點:

– TPU已從只能「推論」到可以支援「訓練+推論」

– TPU的訓練算力已經提升了10倍 (459TFLOPS)

– TPU Pod的算力已經達到 4.1 exaflops (8960個TPU-v5p晶片, exa=10^18)

乍聽數字沒什麼感覺

但是世界最強的超級電腦frontier也就提供1.191 exaflops

TPU Pod其實已經跟世界最猛的超級電腦算力差不多囉XD

而背後持續讓Google推動TPU演進的趨勢是

「More computational power improves models significantly」

翻成白話文就是

「算力是Google開發AI的關鍵資源」

想像一下

當一間公司擁有的AI算力越高

他可以大幅降低訓練時間、減少模型試錯成本

也就能更快發布「下世代」更好的模型

換句話說

「算力」是加速「AI學習曲線」的關鍵

而自研AI晶片則幫助用更低成本獲取算力

▌AI巨頭們的對「算力資本」的競爭

除了Google了解算力對於公司的重要性

我想Sam Altman也早就了解這件事

所以,Sam才會一直吵著說要自研wafer-level的巨型AI晶片

因為當OpenAI在訓練下世代foundation model 時(e.g., GPT-4)

既不缺錢、也不缺頂尖人才、更不缺影響力

最缺的是寶貴的訓練時間

而有算力才能縮短訓練時間

讓OpenAI繼續保持AI Foundation Model的領先

而有自研晶片的好處在於

大規模部屬AI時可降低成本,用低價讓更多使用者使用,搶市佔率

所以,雖然不知道繼ChatGPT、GPT-4、SORA之後的下一個殺手級應用是什麼

但我認為自研AI晶片是OpenAI合理的選擇

但是自己蓋晶圓廠不合理

在了解算力的重要性後

當我們看到Meta大量買進25萬片GPU的新聞時

其實也就不會太驚訝

因為OpenAI、Google、Meta等以AI為核心驅動的公司早已圍繞「算力資本」展開競爭了